基于关系约束的胶囊图网络非刚体形状匹配

中文题目:基于关系约束的胶囊图网络非刚体形状匹配

论文题目:Relation Constrained Capsule Graph Neural Networks for Non-rigid Shape Correspondence

录用期刊:ACM Transactions on Intelligent Systems and Technology(中科院大类4区,JCR Q1)

原文DOI:https://doi.org/10.1145/3688851

作者列表:

1) 连远锋 中国石油大学(北京)人工智能学院 智能科学与技术系 教师

2) 裴守爽 中国石油大学(北京)人工智能学院 计算机科学与技术专业 硕20

3) 陈梦琪 中国石油大学(北京)人工智能学院 计算机科学与技术专业 硕21

4) 华 璟 美国韦恩州立大学 计算机科学系

摘要:

三维动态形状之间的精确对应关系是分析和量化形变的关键任务。针对非刚性三维形状匹配易受拓扑结构变化影响而导致精度降低的问题,提出基于关系约束的胶囊图网络(RC-CGNet),构建嵌入特征空间与输入形状几何特征之间的关系约束,依托函数映射框架,实现三维形状匹配。首先,设计了扩散图注意力网络(DGANet)对三维形状进行语义分割,并对分割结果采样,获得奇点。然后,构建奇点间测地距离最小生成树(minimum spanning tree, MST)作为关系约束,计算正方向和对称方向上的等距匹配关系。为提高算法的收敛速度和匹配精度,提出一种基于Nesterov加速梯度算法(NAG)的优化残差网络结构提取局部特征,并利用图卷积结构提取全局特征。此外,提出了轻量级门控注意力模块来融合全局特征和局部特征,以获得更丰富的特征表示。由于胶囊网络比传统卷积神经网络具有更好的空间推理能力,文中提出了基于路由注意力融合模块(RAFB)的双路由胶囊网络,通过利用语义部分的几何层次关系过滤低区分度胶囊。在公开数据集上的实验结果表明,该方法具有良好的准确性和广泛的适应性。

背景与动机:

非刚性三维形状匹配是计算机视觉领域的研究热点,被广泛应用于形状分析、量化、形状检索和可视化等领域。传统形状匹配算法首先提取三维形状的局部特征描述符或测地距离等几何特征,通过迭代优化匹配关系,获得最终匹配结果。这类方法提取的三维形状描述符鲁棒性较差,因此存在匹配精度较低的问题。深度学习形状匹配算法能够自动提取描述符特征,通过优化函数映射矩阵求得三维形状逐点对应关系,有效提升了匹配精度。近年来,基于深度学习的形状匹配算法取得众多研究成果,但这类方法通常仅提取形状的全局特征,忽略了形状的局部特征与空间几何关系,当模型拓扑结构发生变化时,匹配精度会降低。

设计与实现:

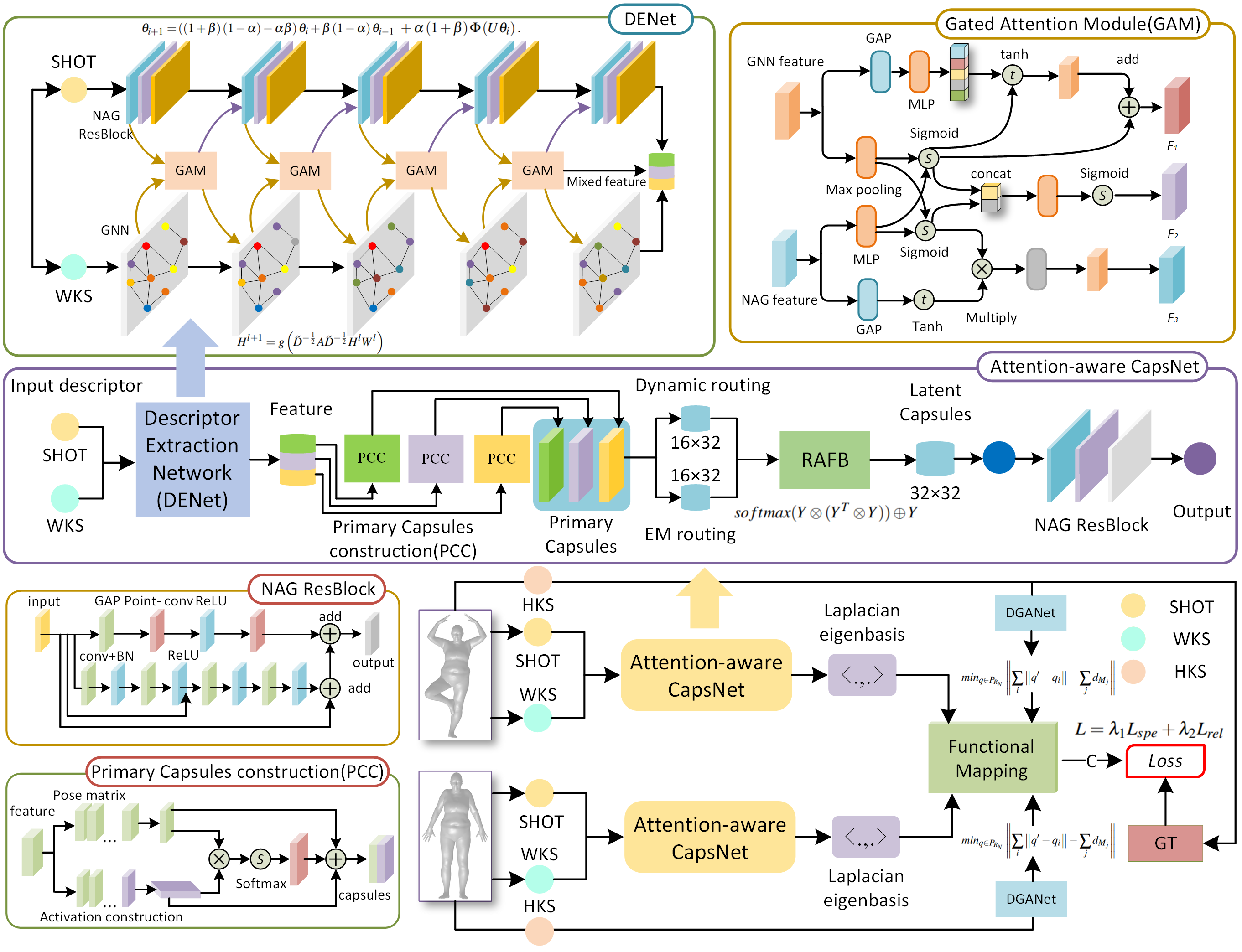

图1给出了本文算法的详细结构。首先通过DGANet对三维模型曲面进行语义分割;然后对分割后的模型采样进而生成奇点;接下来计算奇点间测地距离的最小生成树并生成测地距离矩阵;然后将测地距离矩阵转化为函数映射框架中的关系约束项,计算三维形状的等距匹配关系。最后,通过度量测地线最小生成树中每个点的嵌入特征和输入形状几何特征之间的相似性,构建关系约束损失函数的正则化项,构建关系约束损失函数,实现网络模型的端到端训练。

图1 RC-CGNet网络结构

实验结果及分析:

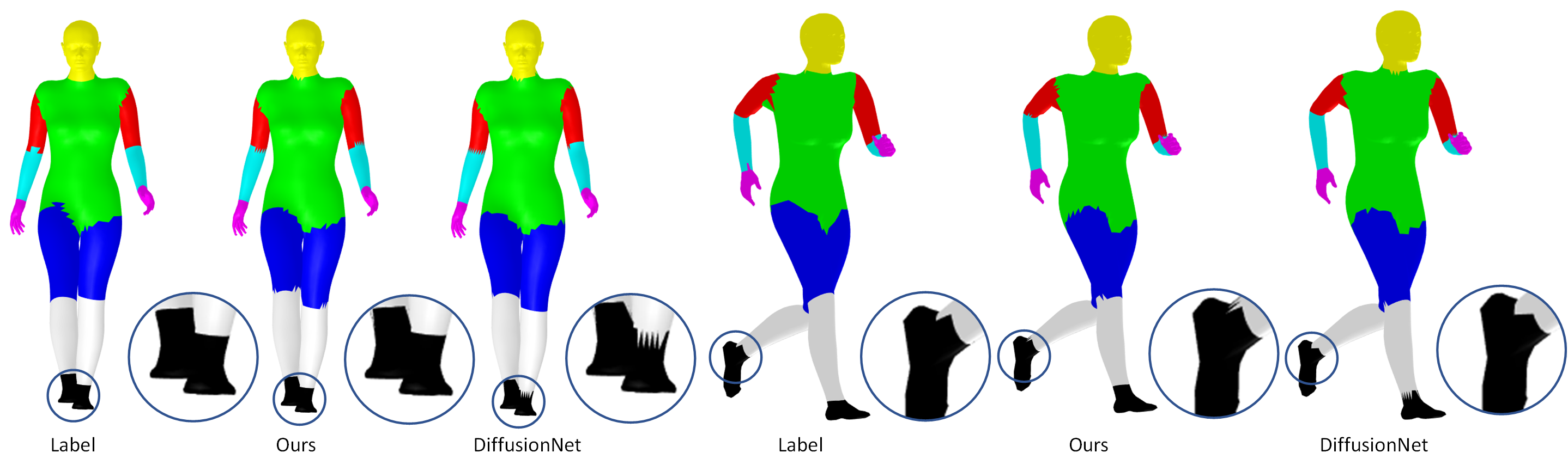

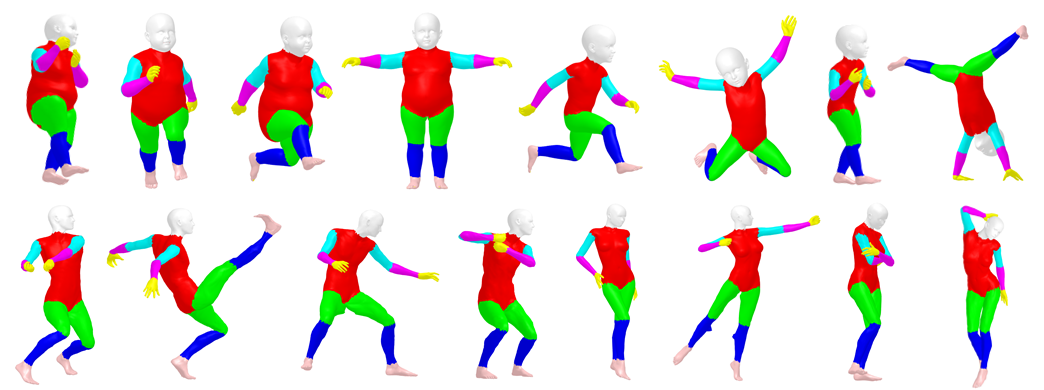

将DGANet在SHREC数据集上的语义分割结果可视化,如图2所示。通过放大局部细节,与DiffusionNet对比,DGANet的语义分割精度高于DiffusionNet,细节更加准确,更接近真实分割结果,证明DGANet具有较强的鲁棒性。进一步,图3第一行、第二行分别展示了KIDS与TOSCA数据集的分割结果。可以看出,对于不同姿势的三维人体模型,本章方法均取得良好的语义分割效果,表现出较强的鲁棒性。

图2 人体模型数据集分割结果对比

图3 本文方法在KIDS和TOSCA数据集上的分割结果

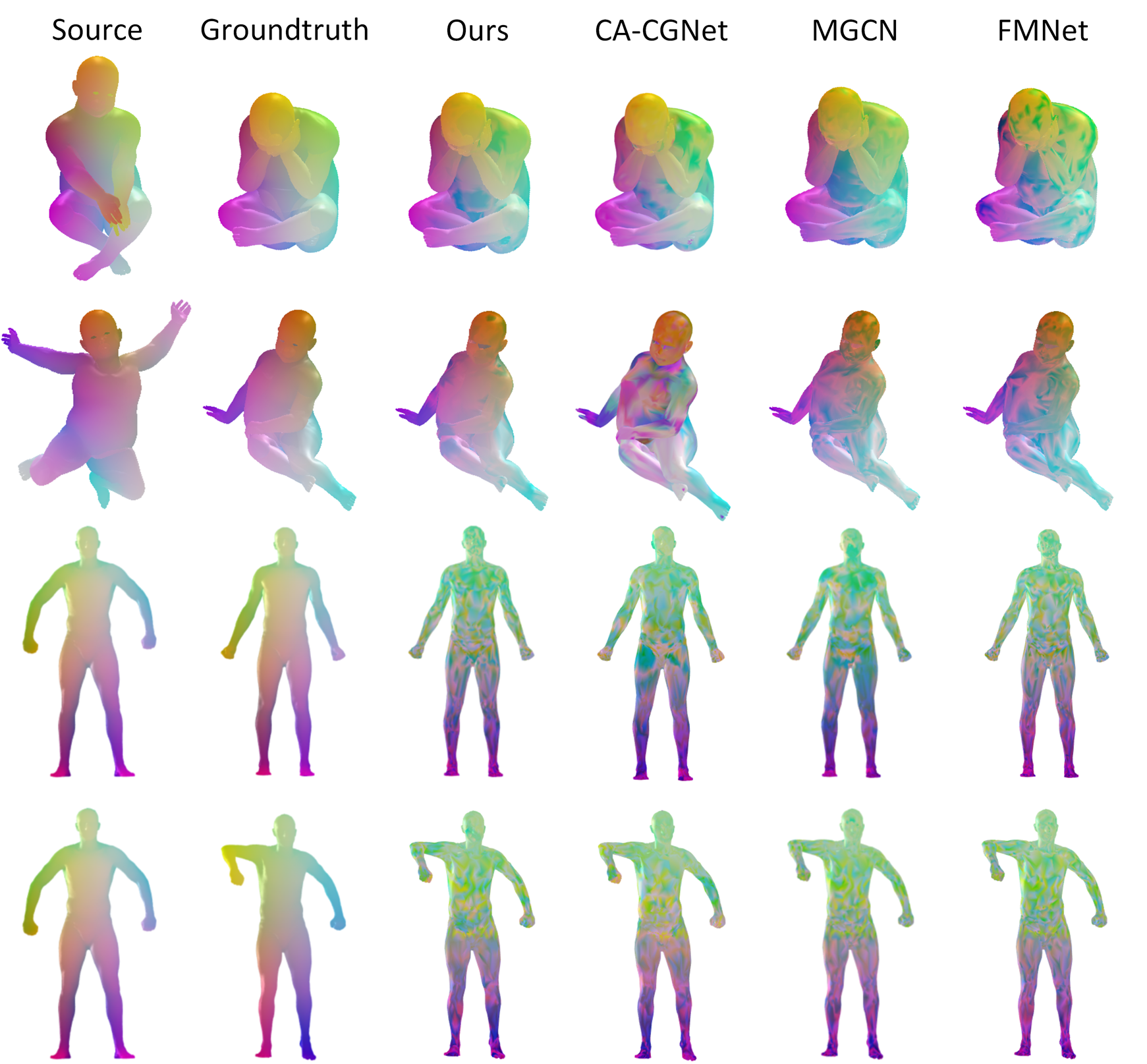

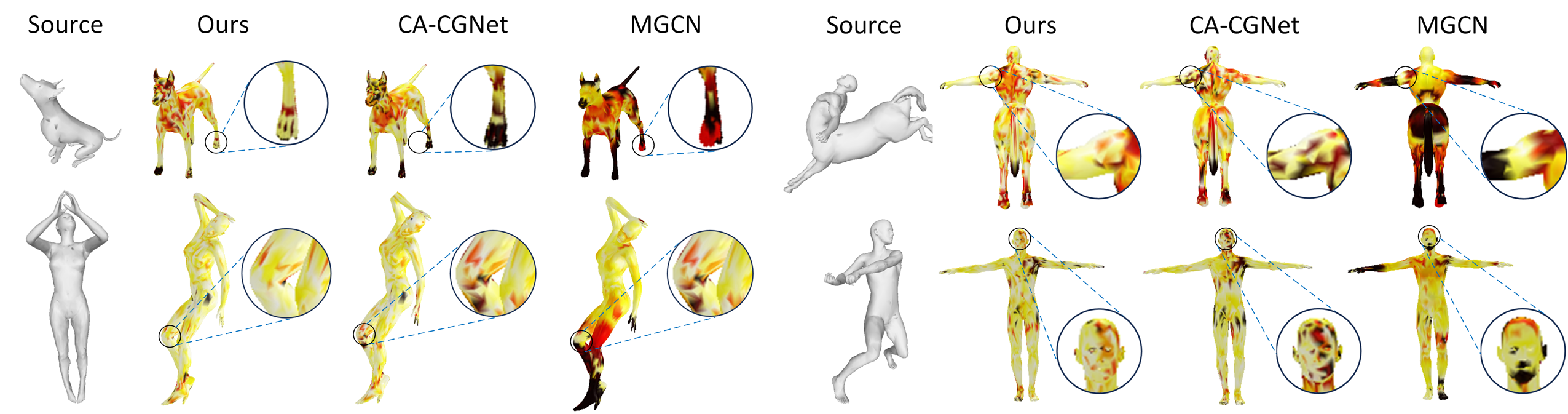

为了更好地展示对比,图4展示了本文方法与CA-CGNet、MGCN和FMNet在重采样的KIDS和SCAPE数据集上的形状匹配结果。可以看出,在重采样的KIDS和SCAPE测试集上,本文方法的性能优于其他三种方法,证明本文方法具有更强的鲁棒性。图5展示了本文方法与CA-CGNet、MGCN在重采样的TOSCA数据集上的测地线误差。实验结果表明,该方法在姿态变化较大的人体模型和非人体模型上均取得了更好的形状匹配精度,表明RC-CGNet具有良好的泛化性。

图4 各种方法在KIDS和SCAPE数据集上的形状匹配结果可视化

图5 不同方法中人体模型和非人体模型测地线误差可视化

结论:

本文以奇点间测地曲线的最小生成树作为关系约束,依托函数映射框架,提出了一种嵌入特征空间和输入形状空间的形状匹配网络。通过将关系约束损失整合为正则化项进一步提高形状匹配性能。在未来的研究中,考虑将胶囊网络扩展到形状的局部表示,并探索关系感知路由机制。

作者简介:

连远锋,教授。研究方向为图像处理与虚拟现实、机器视觉与机器人、深度学习与数字孪生。