在线持续自适应样例相似性嵌入学习

中文题目:在线持续自适应样例相似性嵌入学习

论文题目:Adaptive Instance Similarity Embedding for Online Continual Learning

录用期刊/会议:Pattern Recognition (JCR Q1-Top)

原文DOI:https://doi.org/10.1016/j.patcog.2023.110238

原文链接:

https://www.sciencedirect.com/science/article/pii/S0031320323009354

录用/见刊时间:2024.01.01

作者列表:

1) 韩亚楠 中国石油大学(北京)信息科学与工程学院/人工智能学院 控制科学与工程 博19

2) 刘建伟 中国石油大学(北京)信息科学与工程学院/人工智能学院 自动化系 教师

我们研究了在线持续学习(CL)范式,即学习者必须不断学习一系列任务。在这种情况下,提高模型的学习能力和减轻灾难性遗忘是两个关键因素。请注意,大多数现有的在线持续学习方法都是基于经验h回放策略的。在这种类型的方法中,应用内存缓冲区来存储先前任务的子集,以防止灾难性遗忘。来自当前任务和存储器缓冲器之间的样本被联合训练以更新网络参数。考虑到大多数方法只通过共享特征提取器生成特征嵌入,然后通过交叉熵损失训练网络。我们认为,这种方法未能全面探索特征嵌入内在机制,并忽略了样本之间的相似关系,从而导致判别性能较低,尤其是在在线学习环境中。为此,我们提出了用于在线连续学习的自适应样例相似性嵌入(AISEOCL)框架,该框架进一步考虑了给定批次中的所有样例之间的关系。具体来说,首先,使用经验回放策略来避免灾难性遗忘。然后,在训练过程中,我们应用自适应相似嵌入,从由当前任务和先前任务组成的当前训练样例中获得额外的有价值的相似信息。由于并非所有样例对预测都同等重要,因此我们通过注意力机制进一步权衡每个样例的重要性。重要的是,我们进一步对当前模型和先前模型之间的相似性关系的分布施加了相似性蒸馏损失。这样的操作可以将不同样例之间的相似性关系从旧模型转移到当前模型,以缓解灾难性遗忘。通过这种策略,AISEOCL可以进一步提高模型的学习能力,同时增强判别能力,这也有利于稳定地抵抗遗忘。在几个现有基准数据集上的实验验证了我们提出的方法的有效性。

为了能够实现在线持续学习,学习者应该在能够执行先前任务的同时,从当前任务中不断获得新知识。在线持续学习的最终目标是最大化所有任务的性能。我们注意到,提高模型的学习能力和克服灾难性遗忘是在线持续学习环境中的两个关键因素。有鉴于此,人们对持续学习越来越感兴趣,近年来已经提出了几种方法。为了对抗遗忘,早期的工作试图将额外的正则化项应用于损失函数,在学习新任务时巩固先验知识,如无遗忘学习(LwF)、弹性权重巩固(EWC)。然而,正则化方法可能不足以约束优化过程,特别是在在线设置或具有长序列的情况下,这可能导致较差的全局性能。与正则化方法相比,为了消除灾难性遗忘,基于记忆的方法在情景记忆中保存了一些旧任务的样本,这些样本在学习新数据时会回放,最近的研究发现,这种方法表现出优越的性能。因此,几乎所有现有的在线持续学习方法都是基于经验重放,或者简单地重放。此外,研究人员专注于提高模型的学习能力,如Chelsea等人。将元领导算法扩展到在线持续学习设置中,从而进一步加快和增强新任务的学习能力。基于交叉验证原理,Quang等人通过双层优化提高了模型的泛化能力。注意,大多数方法要么避免灾难性遗忘,要么注重提高学习能力。但是,大多数方法都是通过交叉熵损失来训练网络的。由于这种损失只考虑了样本的类别标签,它们忽略了样本之间的相似关系,导致判别性能较低,这不利于提高整体性能,尤其是在在线持续学习环境中。

设计与实现:

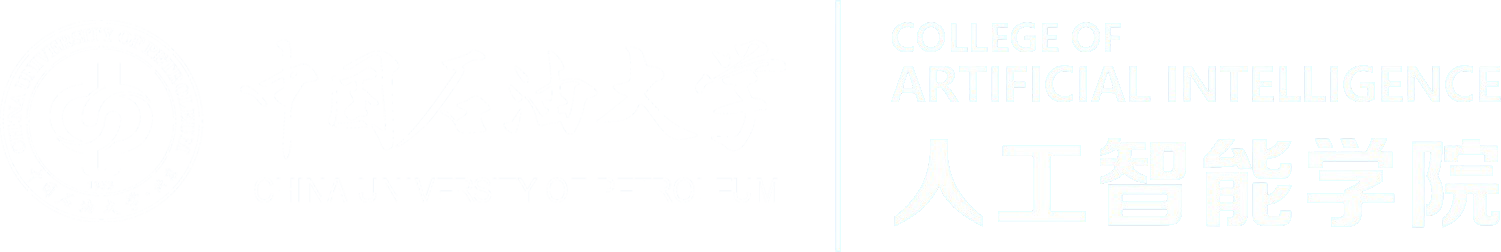

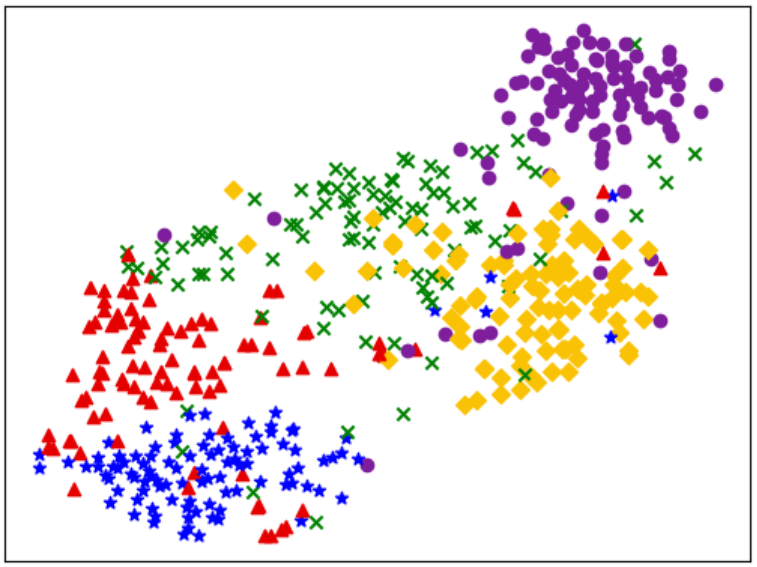

提出的自适应样例相似性嵌入(AISEOCL)框架如下图所示。

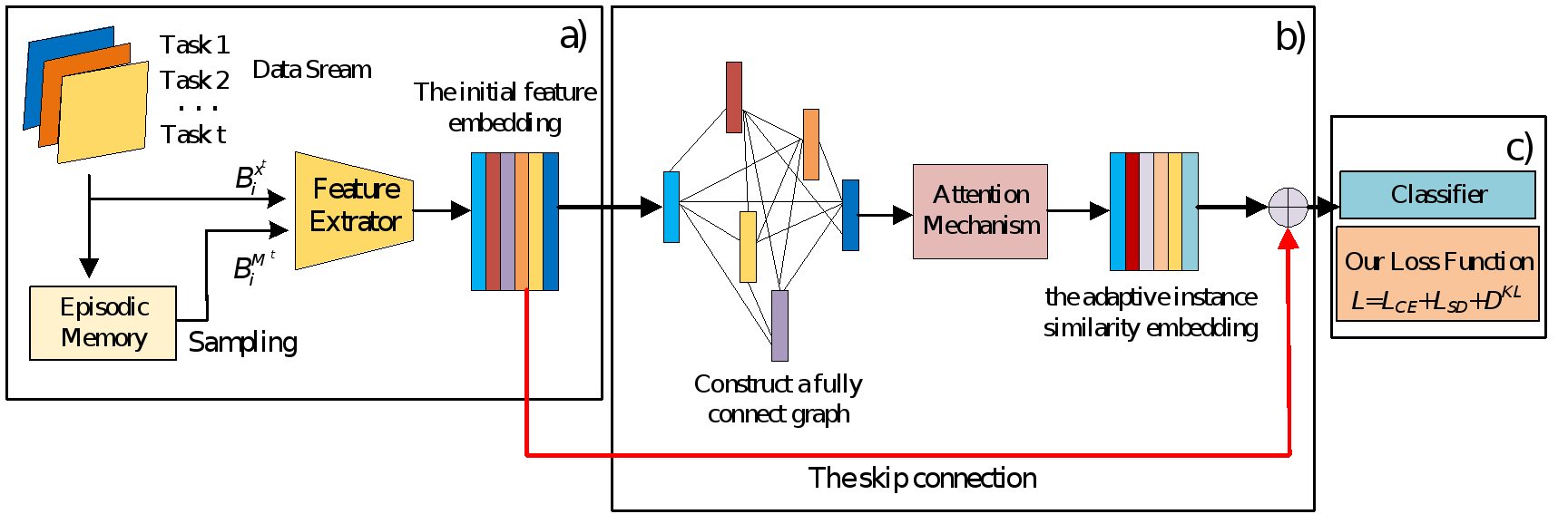

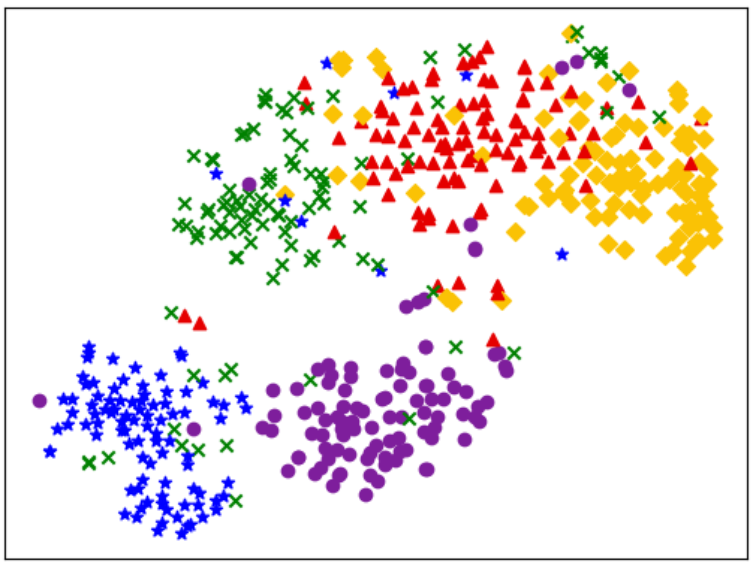

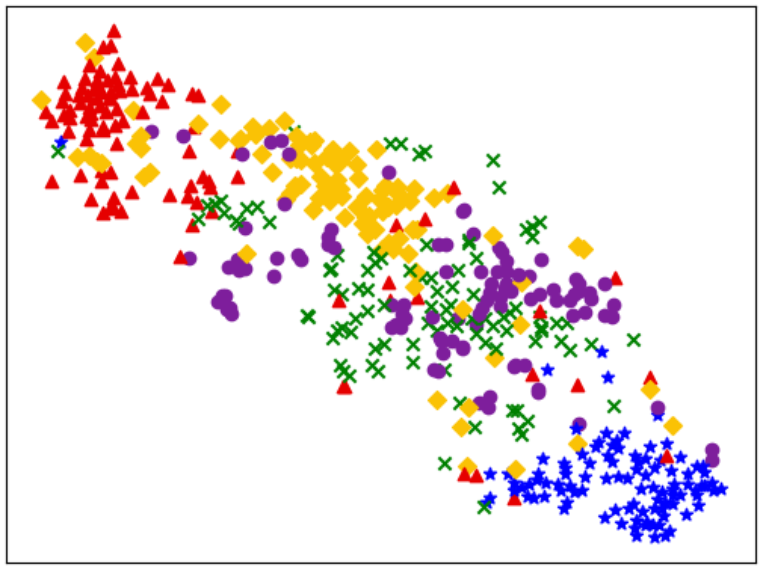

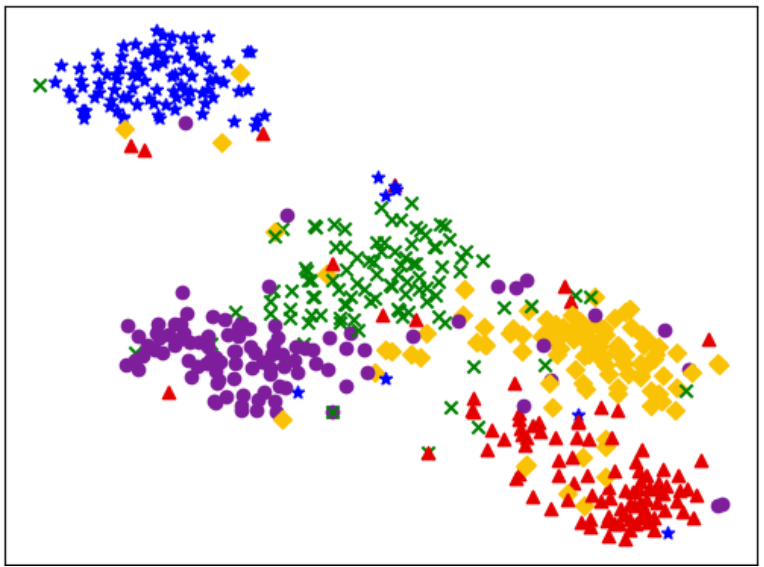

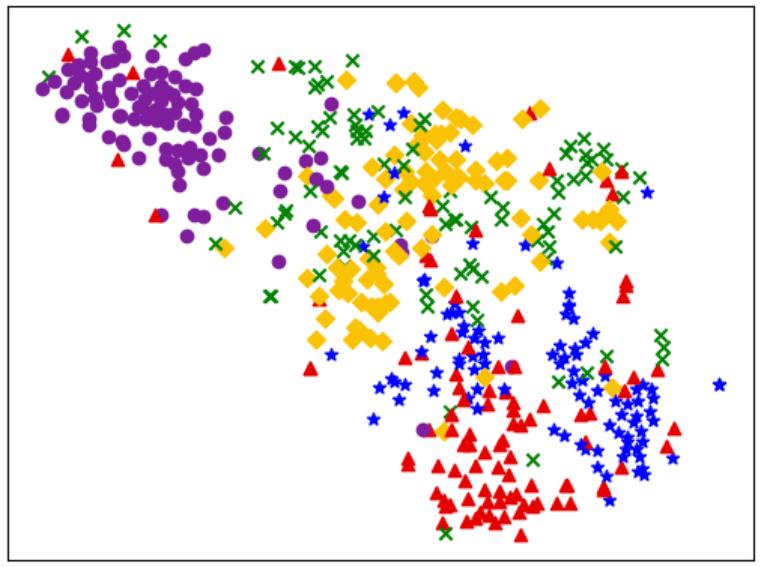

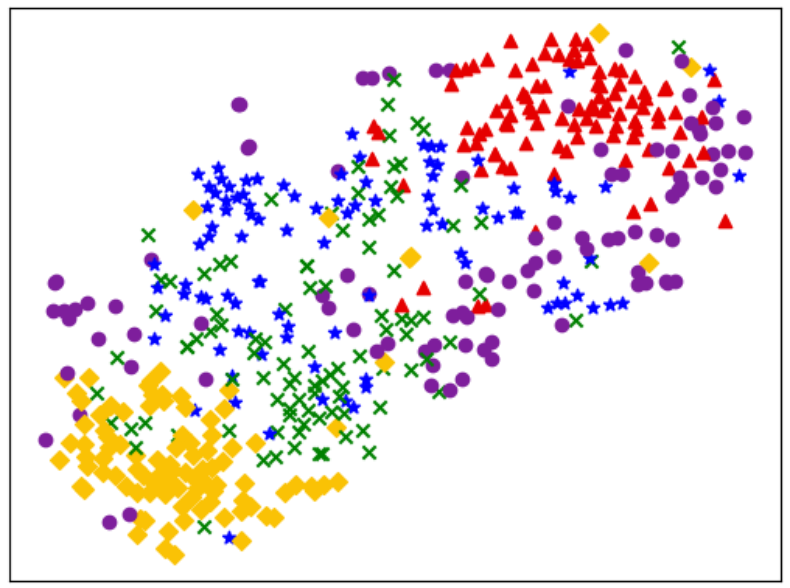

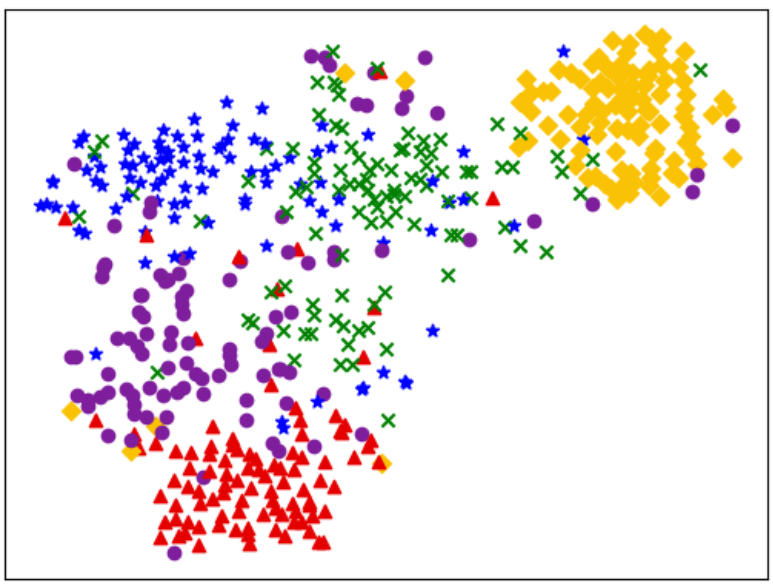

相似蒸馏损失过程图解:

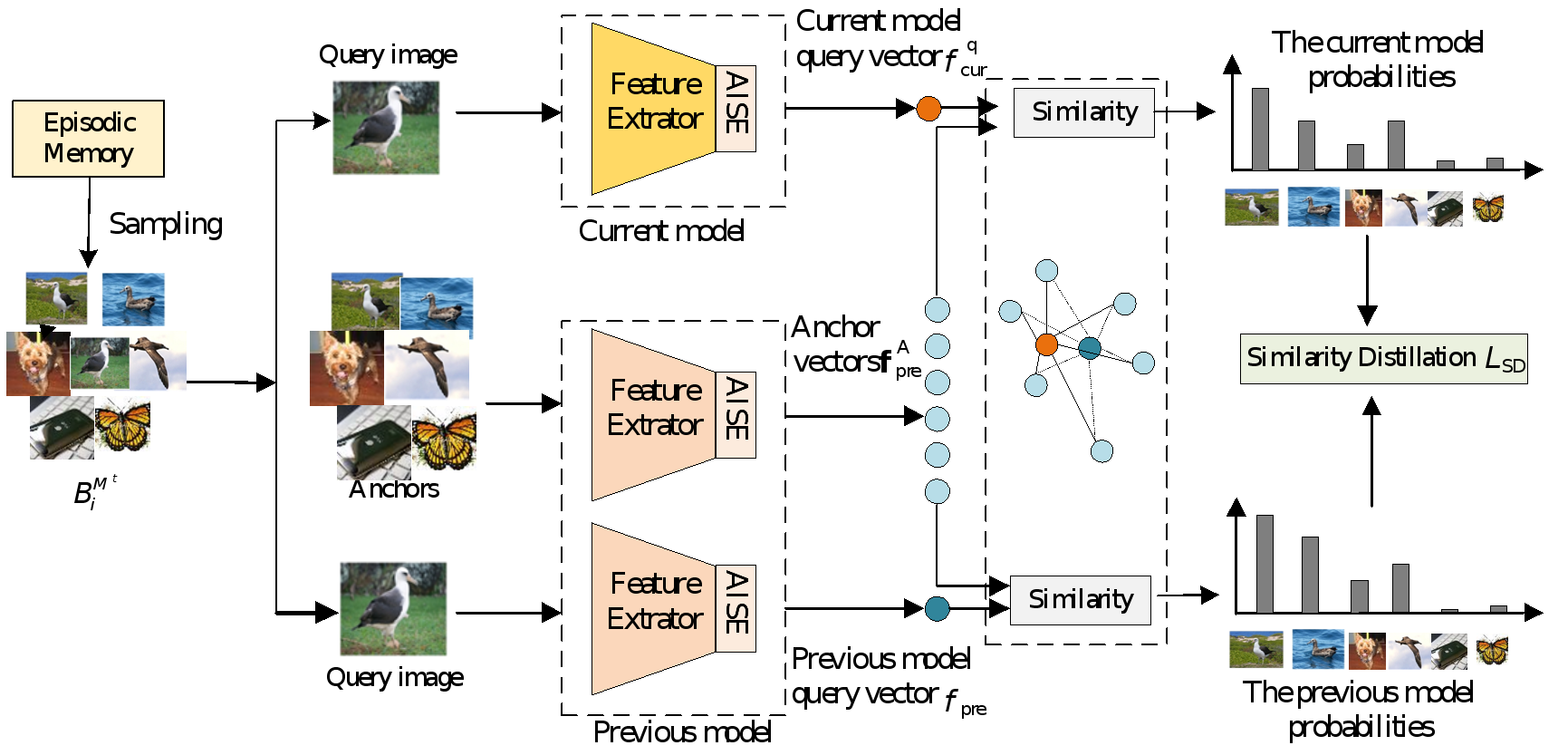

a) Task 1

b) Task 5

c) Task 10

d) Task 15

我们提出了一种新的在线持续学习范式,自适应实例相似性嵌入方法(AISEOCL),无论样本是否属于同一类,该方法可以自适应地计算当前训练批中所有实例之间的相似关系。

我们提出了一种相似性蒸馏损失,可以在经验回放过程中将查询点与先前模型中的锚点相比的相似性转移到当前模型,对抗灾难性遗忘。

该方法可以进一步提高模型的判别性能,使相似样例在特征空间中比不相似样例更接近,从而提高模型的性能。

我们进行了全面的实验比较,和一系列最先进的基准模型比较,验证我们提出的方法的有效性,并进行了消融研究,以进一步了解AISEOCL模型中每个组分的贡献。

刘建伟,教师,学者。研究领域涉及在线学习(包括强化学习,赌博机算法,持续学习,长尾学习);图像视频显著性目标检测,解纠缠表示学习,光场和神经场模型,以及图像视频少样本变化检测;自然语言理解中的知识补全,图神经网络;不平衡数据处理;霍克斯点过程故障预测与诊断;非线性预测与控制。 是兵器装备工程学报第三届编辑委员会委员。历届中国控制会议(CCC)和中国控制与决策会议(CCDC)的程序委员会委员。担任过80多个国际会议的TPC.