可微神经网络模块组装

中文题目:可微神经网络模块组装

论文题目:Differentiable Neural Network for Assembling Blocks

录用期刊/会议:The 27th European Conference on Artificial Intelligence ECAI 2024 (CCF-B类会议)

原文DOI:10.3233/FAIA240747

原文链接:https://doi.org/10.3233/FAIA240747

录用/见刊时间:2024.10

作者列表:

1)刘志伟 中国石油大学(北京)人工智能学院 计算机科学与技术 硕21

2)鲁 强 中国石油大学(北京)人工智能学院 智能科学与技术系副教授

3)赵艺博 中国石油大学(北京)人工智能学院 计算机科学与技术 硕23

4)赵艳红 昆仑数智科技有限责任公司 北京

5)Jake Luo University of Wisconsin Milwaukee Department of Health Informatics and Administration Associate Professor

摘要:

模块组装的目标是针对不同数据集从预训练神经网络模型中选择模块,组合成一个新的神经网络。通过重用这些模块的权重,使得训练变得高效。本文提出一种称为PA-DNN的端到端可微神经网络。PA-DNN由划分神经网络模块和组装神经网络模块组成。其中划分神经网络模块将根据新数据集把现有的预训练神经网络模型划分成模块;组装神经网络模块选择这些模块中的一部分,并使用缝合层将它们组合成新的神经网络。实验结果表明,与手工设计的网络、神经结构搜索方法和神经网络组装方法DeRy相比,PA-DNN能够以更低的训练代价生成更精确、更轻量级的神经网络。

背景与动机:

目前已经积累了大量的神经网络,如HuggingFace和MMPretrain中提供了大量在特定数据集上训练好的模型。虽然这些预先训练的神经网络模型在原始训练数据集上表现较好,但当遇到新的数据集时,它们的性能可能会下降,通常需要手动调整模型结构或重新训练以适配新的数据集,这会耗费大量人力和计算资源。为缓解此问题,本文提出PA-DNN模型最大化重用模型权重,可以有效减少训练成本。

设计与实现:

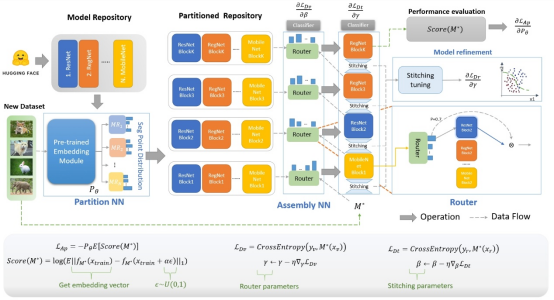

划分组装可微神经网络(PA-DNN)总体框架如图1所示。首先,从类似于 Huggingface 的预训练模型库中选择一些模型作为模型库。基于新数据集,利用划分神经网络模块学习划分点的概率分布,将预训练的模型拆分为模块。在获得划分好的模型库后,组装神经网络模块将通过路由模块(如图2a)来选择其中的一些模块,并使用缝合层(如图2b)将模块连接得到组装模型。训练时利用验证数据集更新路由模块的参数,以指导结构生成;利用训练数据集更新缝合层参数,以适配目标任务。然而,获取组装模型的精度需要多次的前向传播和梯度下降迭代,非常耗时。为了克服这个问题,使用评分函数预测组装模型的精度,无需在评估期间重新训练组合出的神经网络。训练后,PA-DNN 会微调最佳模型的缝合层以适配新的数据集。PA-DNN以端到端的方式完成了网络划分与模块组装。

图1 划分组装可微神经网络模型(PA-DNN)

图2 路由模块和缝合层

实验结果及分析:

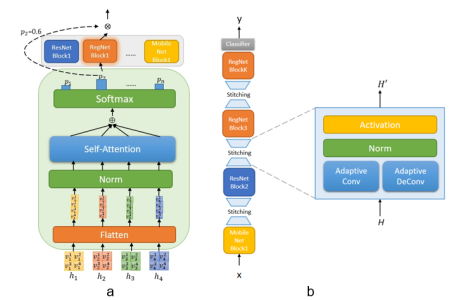

在CIFAR-10和CIFAR-100数据集上分别运行PA-DNN四次得到的模型结构图,其中相同色块表示来源于相同的预训练模型(如图3所示)。

图3模型结构图

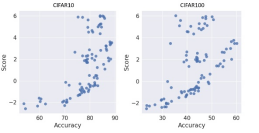

为验证所提出的评分函数,在NAS-Bench-201数据集上进行实验。如图4所示,性能评估得分和模型准确率整体上呈线性正相关。

图4 评分函数与模型精度关系图

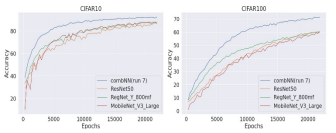

图5 验证准确率对比结果

图6 准确率和训练参数对比结果

结论:

本文提出了一种新的神经网络模块组装方法——划分组装可微神经网络(PA-DNN)。该方法使用端到端的可微分神经网络来从神经网络模型库中组装神经网络模块。PA-DNN主要由两个部分组成:划分神经网络模块和组装神经网络模块,分别负责模型划分和网络组装。与手工设计的模型、神经结构搜索方法和DeRy方法相比,PA-DNN以较小的搜索成本组装出新的网络,并以较小的训练成本就可以得到较好的模型表现。

通讯作者简介:

鲁强:副教授,博士生导师。目前主要从事演化计算和符号回归、知识图谱与智能问答、以及轨迹分析与挖掘等方面的研究工作。

联系方式:luqiang@cup.edu.cn