区域动态点云补全网络

中文题目:区域动态点云补全网络

论文题目:Regional Dynamic Point Cloud Completion Network

录用期刊/会议:Pattern Recognition Letters (中科院大类3区)

原文DOI: https://doi.org/10.1016/j.patrec.2024.10.017

录用时间:2024.10.31

作者列表:

1) 朱丽萍 中国石油大学(北京)人工智能学院 计算机系教师

2) 杨逸萱 中国石油大学(北京)人工智能学院 计算机技术 硕22

3) 刘 凯 中国石油大学(北京)人工智能学院 计算机科学与技术 硕22

4) 吴祀霖 中国石油大学(北京)人工智能学院 计算机科学与技术 硕22

5) 王丙垚 中国石油大学(北京)人工智能学院 计算机技术 硕19

6) 常宪祥 中国石油大学(北京)人工智能学院 计算机科学与技术 硕22

背景与动机:

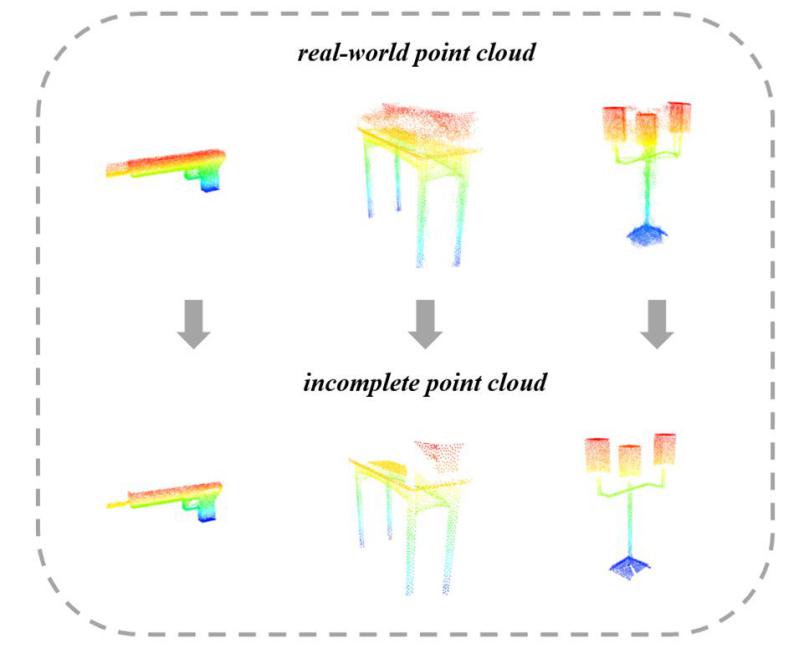

随着 3D 传感器技术的进步,点云成为捕获 3D 信息的重要手段。迄今为止,点云在虚拟现实、三维重建和自动驾驶汽车等各个领域都得到了广泛的应用。点云数据很容易通过激光扫描仪或深度相机获取。尽管如此,由于遮挡和传感器分辨率有限,来自3D扫描仪和深度相机的原始点云通常是稀疏的和不完整的,如图1所示。这导致缺乏语义信息,给深度学习和后续任务带来了挑战。

现有的几何补全方法,如基于体素的方法,在更高分辨率下计算成本很高,而将点云和网格数据转换为传统格式会引入冗余并模糊数据的不变性。因此,需要基于点云的形状补全方法来解决几何缺失问题,提高后续任务效率。

图1 真实世界对象(上图)与3D扫描仪捕获的不完整数据(下图)之间的比较

设计与实现:

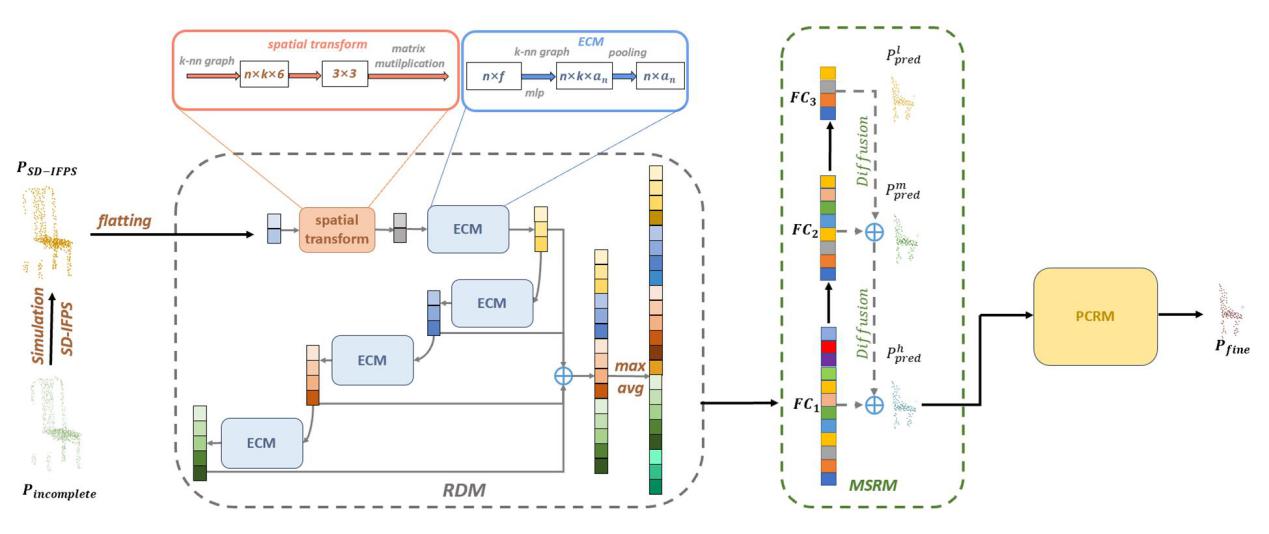

在本文中,我们提出了一种新颖的形状补全网络,即 RD-Net。该网络包含三个关键模块:区域动态模块(RDM)、多尺度重建模块(MSRM)和点云细化模块(PCRM)。我们引入RDM通过迭代EdgeConv增强了网络提取语义和几何信息的能力。我们将MSRM设计为插件可定制模块,通过结合不同分辨率的特征来处理具有相对复杂表面的几何图形。我们提出了PCRM自适应聚合局部邻域特征,通过学习相邻点的关系来有效地生成结构细节。整体框架图如图2所示。

图2 RD-Net的整体架构

首先,由于大多数三维点云数据量太大,如果点云数据直接输入到网络中,它将带来太多的计算,最终使性能差。我们对原始数据进行采样以适合大小的子网络。基于FPS,我们通过增加点集的存储空间来迭代地对代表点进行采样,为采样过程设计了一组类似“管道”的过程,从而提高了时间的利用率。

其次,以前的点云特征提取方法使用了基于多层感知器 (MLP) 的方法。然而,仅依靠 MLP 进行特征提取可能会导致点云的局部特征不足,生成的对象只有共同特征而不是局部特征。第一个子网络区域动态模块(RDM)使用EdgeConv构造点之间的关系来获取局部区域信息,然后通过连续叠加得到全局信息。在迭代EdgeConv的过程中,我们通过特征空间中的相对关系获得更丰富的语义信息。

由于高分辨率点云特征的密集性质,当只使用高分辨率点云生成形状时,点云不规则局部区域的细节会丢失。对于第二个子网络多尺度重建模块(MSRM),我们使用FPN的分层性质来设计多尺度结构来预测缺失的点云。与 2D 网络中提到的反馈机制类似,我们从高到低处理点云分辨率,然后使用小规模分支再次向高尺度提供信息。不同尺度的分支进行特征融合,重建更精细的点云。

最后,以前的方法可以利用局部点特征来保留观测到的几何细节,但不能有效地生成结构信息(如几何对称性)来恢复局部观测条件下的缺失部分。为了进一步增强结构关系,在第三个子网络中,我们提出了残差连接模块(Residual Connection Module, RCM)模块,该模块利用学习到的邻点关系自适应聚合局部邻点特征,以增加点云结构的详细特征。

实验结果及分析:

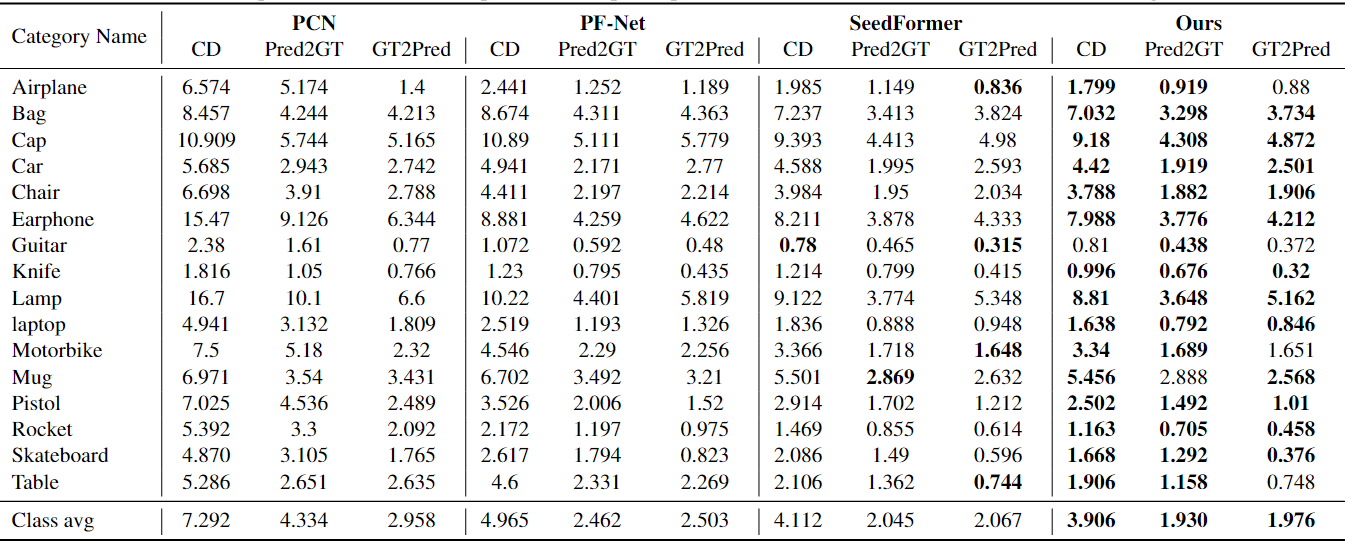

在 ShapeNet-part数据集上地表现如表1所示,我们的 RD-Net 在具有相同输入和裁剪大小的 ShapeNet-part(16) 数据集的大多数类别上实现了最低的 CD 误差。

表1 ShapeNet-part(16) 上补全结果的比较

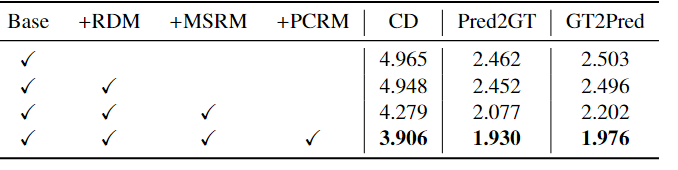

表2 消融实验

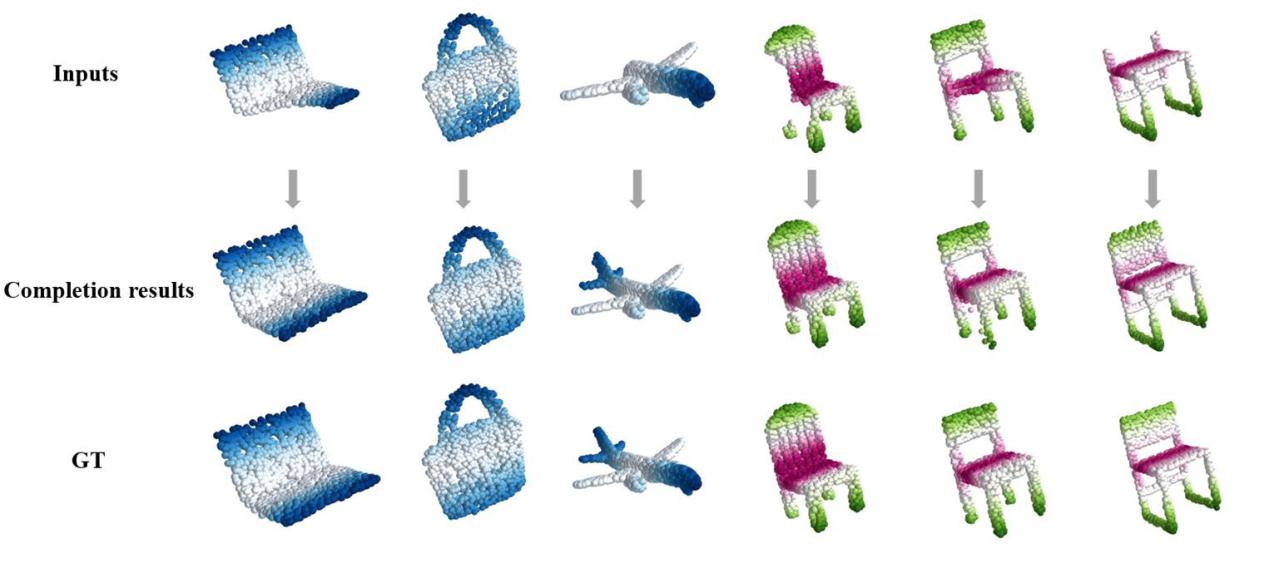

图3 形状补全结果

结论:

在本文中,我们提出了RD-Net用于高质量的点云补全。首先,SD-IFPS旨在提供一种高效的均匀采样点提取方法。其次,RDM捕获局部几何特征,同时保持排列不变性,支持不同深度和尺度的层。第三,在保留现有轮廓的前提下,生成具有丰富语义轮廓和详细特征的目标点云。最后,PCRM对完成的点云进行进一步细化。RD-Net完成局部形状,提高补全质量。该模型在ShapeNet-part数据集上取得了较高的精度。

作者简介:

朱丽萍,博士,中国石油大学(北京)计算机系副教授,硕士生导师。目前主要研究方向是大数据和数据挖掘方向,尤其关注深度学习在计算机视觉方向上的应用,已发表论文多篇高水平论文。

联系方式:zhuliping@cup.edu.cn