深度学习批归一化及其相关算法研究进展

原文信息

发表期刊:自动化学报,2020,中文核心期刊,EI收录

原文DOI:https://doi.org/10.16383/j.aas.c180564

作者列表

1) 刘建伟 中国石油大学(北京) 信息科学与工程学院 自动化系

2) 赵会丹 中国石油大学(北京) 信息科学与工程学院 自动化系 2016级硕士

3) 罗雄麟 中国石油大学(北京) 信息科学与工程学院 自动化系

4) 许 鋆 哈尔滨工业大学(深圳) 机电工程与自动化学院

文章简介

近年来,深度学习获得了广泛应用,如语音识别与合成、计算机视觉、机器翻译和多模态问题回答等。传统机器学习直接处理自然数据的能力有限,需要专业人士对未处理过的数据人工提取特征和人工进行标注,而深度神经网络则可以从原始数据中直接学习多级不同抽象层次的特征,随着网络层数的加深,可以学习数据更高层次的抽象表示,得到的特征甚至可能是人类专家无法发现的。

随着互联网技术的发展,深度神经网络需要处理的数据集越来越趋于大型化和异构,为了获得数据不同抽象层次的特征表示,网络的层数在逐渐增多,甚至达到几百层,导致网络训练花费的时间越来越长,训练过程中容易出现梯度消失和爆炸等问题,网络易陷入局部极小值,训练准确率也有待提升。

GPU的使用加快了深度神经网络的训练速度,其可以将数据集拆分,给不同的处理器进行训练;或者将神经网络进行拆分,每个处理器训练网络的一部分。但是直到今天,新的深度学习算法和深度神经网络新的应用表明,深度神经网络的训练过程还是会受到计算能力的限制。因此很多学者致力于改进训练算法,以加快神经网络的收敛速度。

2013年,批归一化法(Batch Normalization, BN)被发现可以减少中间协变量迁移问题,加快神经网络梯度下降训练过程的收敛速度。把BN作为神经网络的一部分,可以使每一层的输入有相同的、稳定的分布。BN通过引入两个和神经网络训练参数可以一起训练的参数,保留了神经网络的原始表示能力;是可微的变换,并且对梯度反向传播有好处;可以使神经网络训练过程对参数初值不再敏感;允许梯度迭代过程使用更大的学习率,且不会引起梯度更新过程发散;也可以看作是正则化过程,使得目前作为标准配置的dropout并非必须;允许网络使用饱和非线性激活函数,且保证非线性激活函数值不会陷入饱和区。BN简单有效,配合其它手段可以有效提升神经网络的训练速度,并且可以在一定程度上提升神经网络的预测准确率,被应用到如卷积神经网络、递归神经网络、分片线性神经网络和域自适应学习等神经网络领域。

BN通过引入两个和神经网络训练参数可以一起训练的参数,保留了神经网络的原始表示能力;是可微的变换,并且对梯度反向传播有好处;可以使神经网络训练过程对参数初值不再敏感;允许梯度迭代过程使用更大的学习率,且不会引起梯度更新过程发散;也可以看作是正则化过程,使得目前作为标准配置的dropout并非必须;允许网络使用饱和非线性激活函数,且保证非线性激活函数值不会陷入饱和区。

BN简单有效,配合其它手段可以有效提升神经网络的训练速度,并且可以在一定程度上提升神经网络的预测准确率,被应用到如卷积神经网络、递归神经网络、分片线性神经网络和域自适应学习等神经网络领域。

作为人工智能重大突破的AlphaGo Zero,主要原理是卷积神经网络和强化学习相结合,含有很多个卷积层,每一个卷积层之后,都使用BN来规范化层输入,以减少了这些网络中中间协变量迁移的现象,加快训练过程的收敛速度。

BN也存在一些问题,如对mini-batch数据集的大小过分依赖,无法使用单个样本进行训练,训练和推理时计算过程不同。很多基于BN的改进结构和算法被提出,这些改进的结构和算法应用到某些特定领域时可以产生优化效果,但是也可能会提高计算复杂性,并限制其适用的领域。到目前为止,BN仍是深度神经网络训练过程使用最广泛的归一化手段。

主要内容

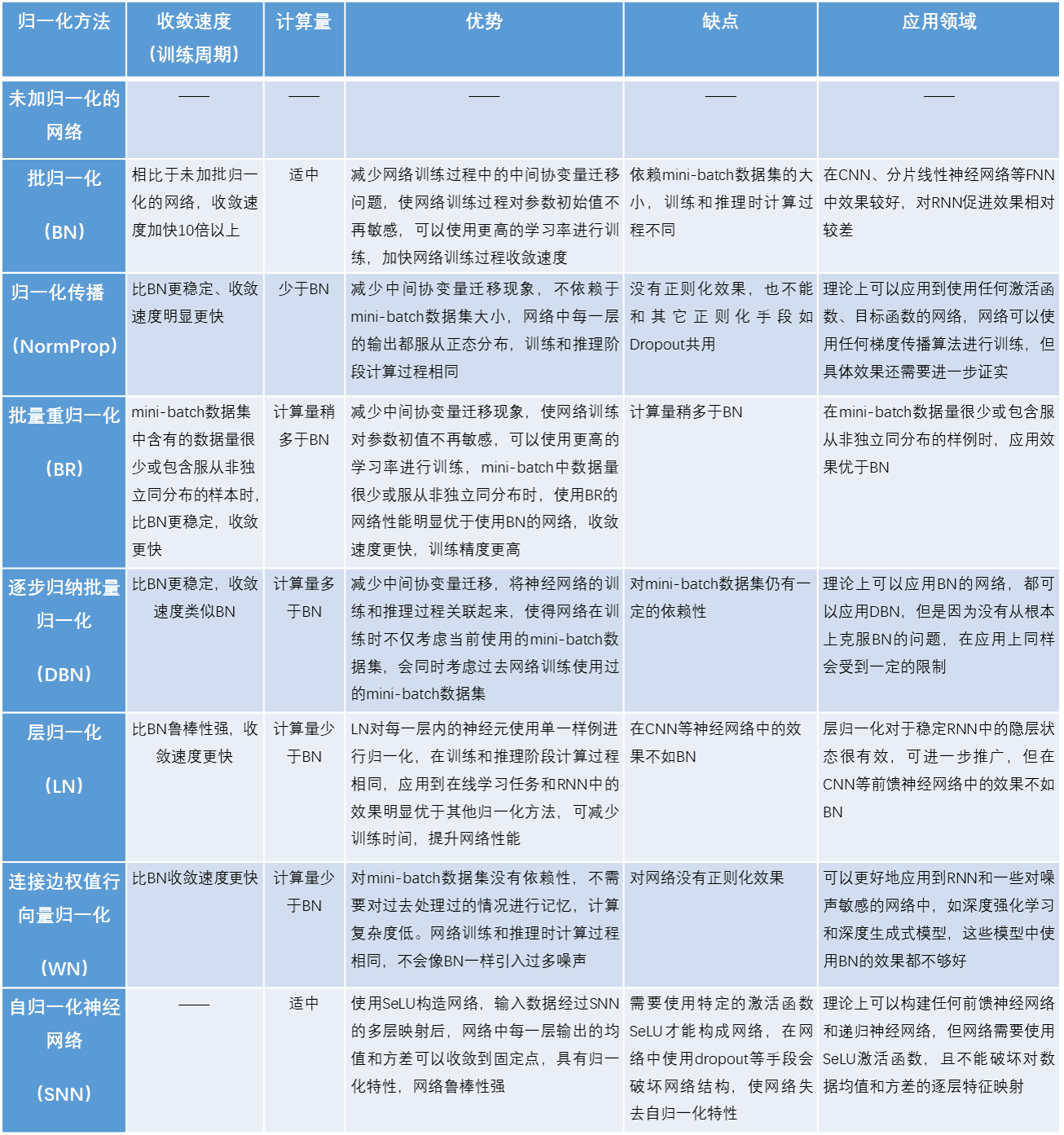

表1对未加归一化的网络、批归一化(BN)、归一化传播(NormProp)、批量重归一化(BR)、逐步归纳批量归一化(DBN)、层归一化(LN)、连接边权值行向量归一化(WN)和自归一化神经网络(SNN)的收敛速度、计算复杂性、优势、缺点和应用领域进行了总结。

表1 批归一化及其相关算法功能对比

关于作者

刘建伟:

博士生导师/硕士生导师。长期从事模式识别与智能系统、复杂系统分析与智能控制、机器学习和数据挖掘方面的研究工作。美国数学会《数学评论》评论员,中国人工智能学会机器学习分会高级会员。在计算机学报,自动化学报、计算机研究与发展、Neurocomputing、TNNLS等期刊上和国内国际会议上发表学术研究论文200多篇,其中三大检索150多篇。

联系方式:

liujw@cup.edu.cn